SEO规则

引擎规范

SEO元素

网站内容

Robots.txt 一个文本文件,放置在网站的根目录中,用来告知搜索引擎哪些页面可以被抓取,哪些页面不可以被抓取。它能够有效地控制谷歌蜘蛛的抓取行为,优化抓取和索引过程,保护网站隐私和安全,提升网站的整体SEO表现。合理配置robots.txt 文件,对于提高网站在谷歌搜索结果中的排名和表现至关重要。

它在 SEO 中的重要性:

控制抓取:通过 robots.txt 文件,网站管理员可以控制搜索引擎蜘蛛抓取网站的哪些部分。这有助于避免抓取不必要的页面,节省抓取预算。

保护敏感信息:可以防止搜索引擎抓取和索引敏感信息或不希望公开的页面,如管理后台、用户隐私信息等。

提升网站性能:避免抓取一些动态生成的页面或重复内容,可以减少服务器负载,提高网站的性能和用户体验。

优化抓取频率:通过 robots.txt 文件,可以引导搜索引擎更频繁地抓取重要页面,提升这些页面的索引和排名。

规范网站结构:帮助搜索引擎理解网站的结构,提高网站的索引效率和准确性。

Robots.txt 文件的基本格式

User-agent: *

Disallow: /admin/

Allow: /public/

Sitemap: http://www.example.com/sitemap.xml

User-agent:指定搜索引擎蜘蛛,* 表示所有搜索引擎。

Disallow:指定不允许抓取的路径。

Allow:指定允许抓取的路径(通常在某些情况下用于覆盖 disallow 规则)。

Sitemap:指定网站地图的 URL,帮助搜索引擎更好地索引网站内容。

规范详细解读:

1、robots.txt 文件应位于网站的根目录下;

2、文件由一条或多条规则组成。每条规则可禁止或允许所有或特定抓取工具抓取;

3、文件不禁止的,默认所有文件均可抓取

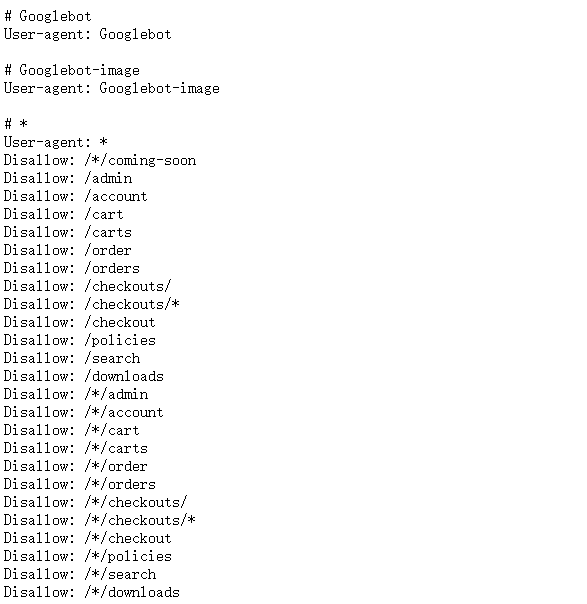

示例:

User-agent: *

Disallow: /*/coming-soon

Disallow: /admin

Disallow: /account

Disallow: /cart

参考网站:

谷歌官方说明:

1、robots.txt 文件有何用途?

robots.txt 文件主要用于管理流向您网站的抓取工具流量,通常用于阻止 Google 访问某个文件(具体取决于文件类型):

(1)网页:对于网页(包括 HTML、PDF,或其他 Google 能够读取的非媒体格式),您可在以下情况下使用 robots.txt 文件管理抓取流量:您认为来自 Google 抓取工具的请求会导致您的服务器超负荷;或者,您不想让 Google 抓取您网站上的不重要网页或相似网页。

如果您使用 robots.txt 文件阻止 Google 抓取您的网页,则其网址仍可能会显示在搜索结果中,但搜索结果不会包含对该网页的说明。而且,内嵌在被屏蔽的网页中的图片文件、视频文件、PDF 文件和其他非 HTML 文件都会被排除在抓取范围之外,除非有其他允许抓取的网页引用了这些文件。如果您看到了这样一条与您网页对应的搜索结果并想修正它,请移除用于屏蔽该网页的 robots.txt 条目。如果您想从 Google 搜索结果中完全隐藏该网页,请改用其他方法。

警告:如果您不想让自己的网页(包括 PDF 和受 Google 支持的其他基于文本的格式)显示在 Google 搜索结果中,请不要将 robots.txt 文件用作隐藏网页的方法。如果其他网页通过使用说明性文字指向您的网页,Google 在不访问您网页的情况下仍能将其网址编入索引。如果您想从搜索结果中屏蔽自己的网页,请改用其他方法,例如使用密码保护或 noindex。

(2)媒体文件:您可以使用 robots.txt 文件管理抓取流量并阻止图片、视频和音频文件出现在 Google 搜索结果中。这不会阻止其他网页或用户链接到您的图片/视频/音频文件。

(3)如果您认为在加载网页时跳过诸如不重要的图片、脚本或样式文件之类的资源不会对网页造成太大影响,您可以使用 robots.txt 文件屏蔽此类资源。不过,如果缺少此类资源会导致 Google 抓取工具更难解读网页,请勿屏蔽此类资源,否则 Google 将无法有效分析有赖于此类资源的网页。

2、robots.txt 文件的限制

在创建或修改 robots.txt 文件之前,您应了解这种网址屏蔽方法的限制。根据您的目标和具体情况,您可能需要考虑采用其他机制来确保搜索引擎无法在网络上找到您的网址。

(1)并非所有搜索引擎都支持 robots.txt 规则。

robots.txt 文件中的命令并不能强制规范抓取工具对网站采取的行为;是否遵循这些命令由抓取工具自行决定。Googlebot 和其他正规的网页抓取工具都会遵循 robots.txt 文件中的命令,但其他抓取工具未必如此。因此,如果您想确保特定信息不会被网页抓取工具抓取,我们建议您采用其他屏蔽方法,例如用密码保护您服务器上的隐私文件。

(2)不同的抓取工具会以不同的方式解析语法。

虽然正规的网页抓取工具会遵循 robots.txt 文件中的规则,但每种抓取工具可能会以不同的方式解析这些规则。您需要好好了解一下适用于不同网页抓取工具的正确语法,因为有些抓取工具可能会无法理解某些命令。

(3)如果其他网站上有链接指向被 robots.txt 文件屏蔽的网页,则此网页仍可能会被编入索引。

尽管 Google 不会抓取被 robots.txt 文件屏蔽的内容或将其编入索引,但如果网络上的其他位置有链接指向被禁止访问的网址,我们仍可能会找到该网址并将其编入索引。因此,相关网址和其他公开显示的信息(如相关页面链接中的定位文字)仍可能会出现在 Google 搜索结果中。若要正确阻止您的网址出现在 Google 搜索结果中,您应为服务器上的文件设置密码保护、使用 noindex meta 标记或响应标头,或者彻底移除网页。

3、实用的 robots.txt 规则